Coze Loop

综合介绍

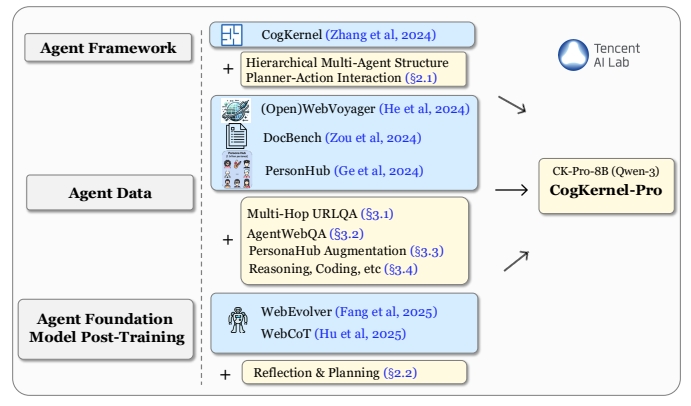

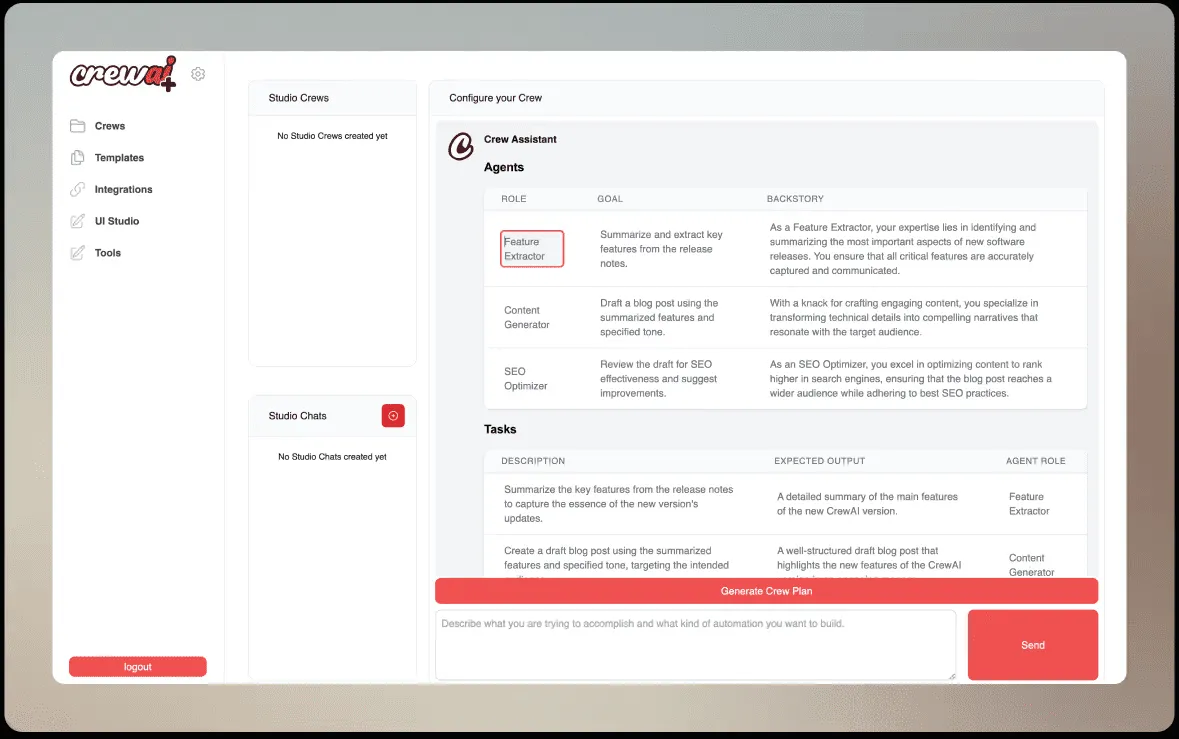

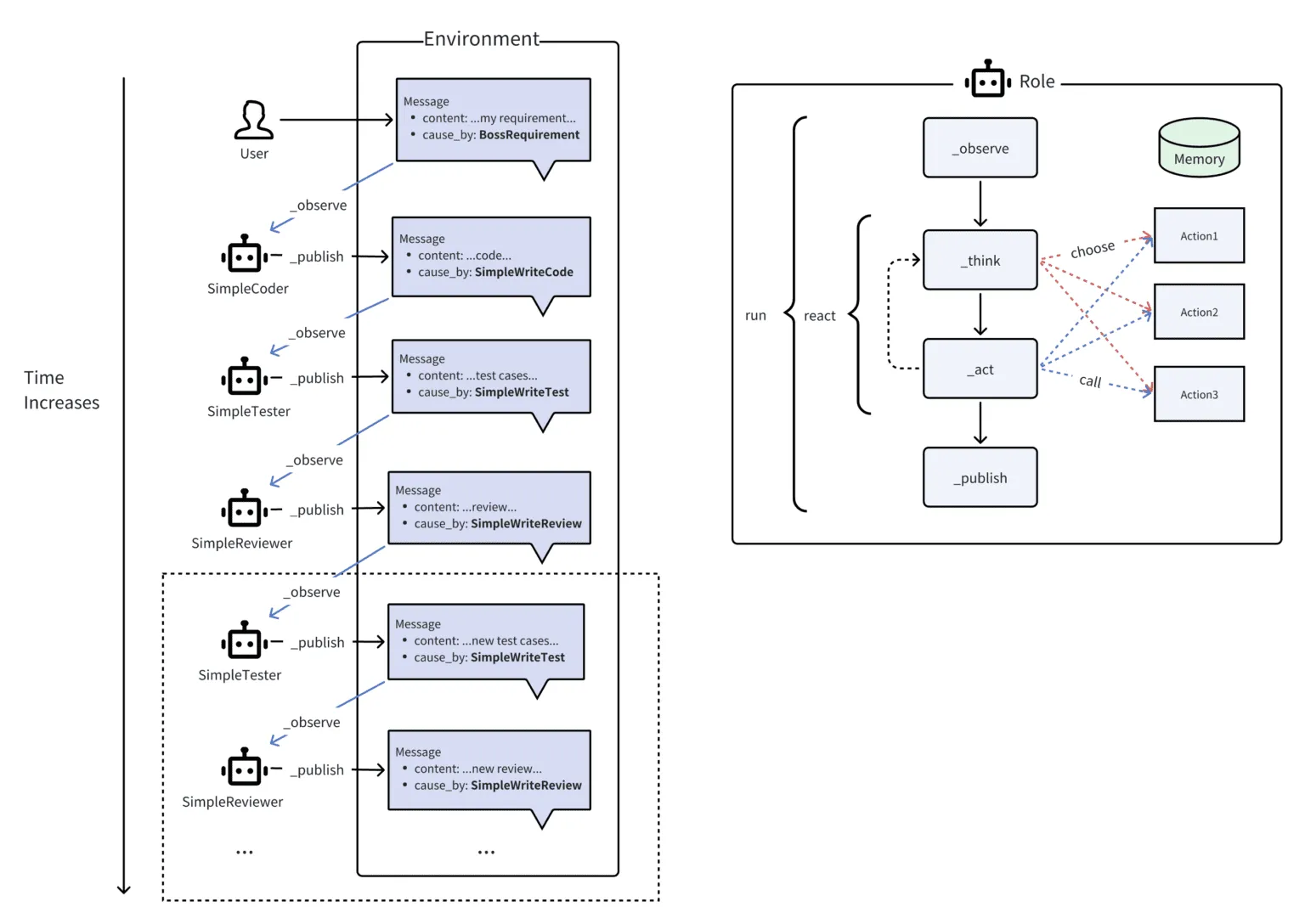

Coze Loop 是一个面向AI应用开发者的平台级解决方案,专注于AI智能体(Agent)的开发与运营。它提供了一套从开发、调试、评估到监控的AI智能体全生命周期管理能力。这个项目是字节跳动旗下Coze生态的商业版能力的开源实现,旨在通过开放核心技术框架,让开发者可以根据自身业务需求进行自由的定制和扩展。Coze Loop的目标是帮助开发者高效地进行提示词工程、系统化地评估智能体表现,并对智能体的线上运行过程进行精细化观测,从而简化开发流程,提升AI智能体的最终性能和稳定性。

功能列表

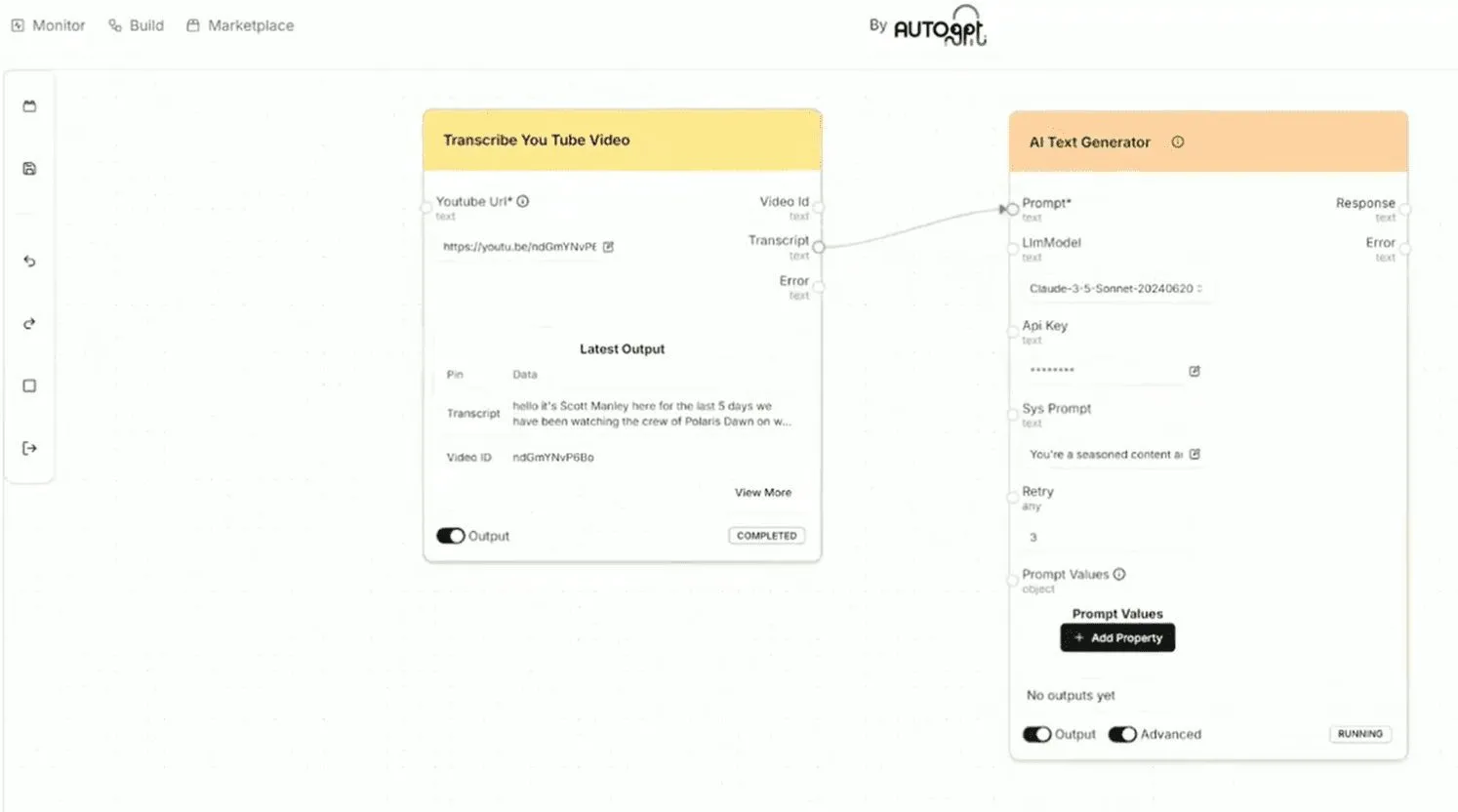

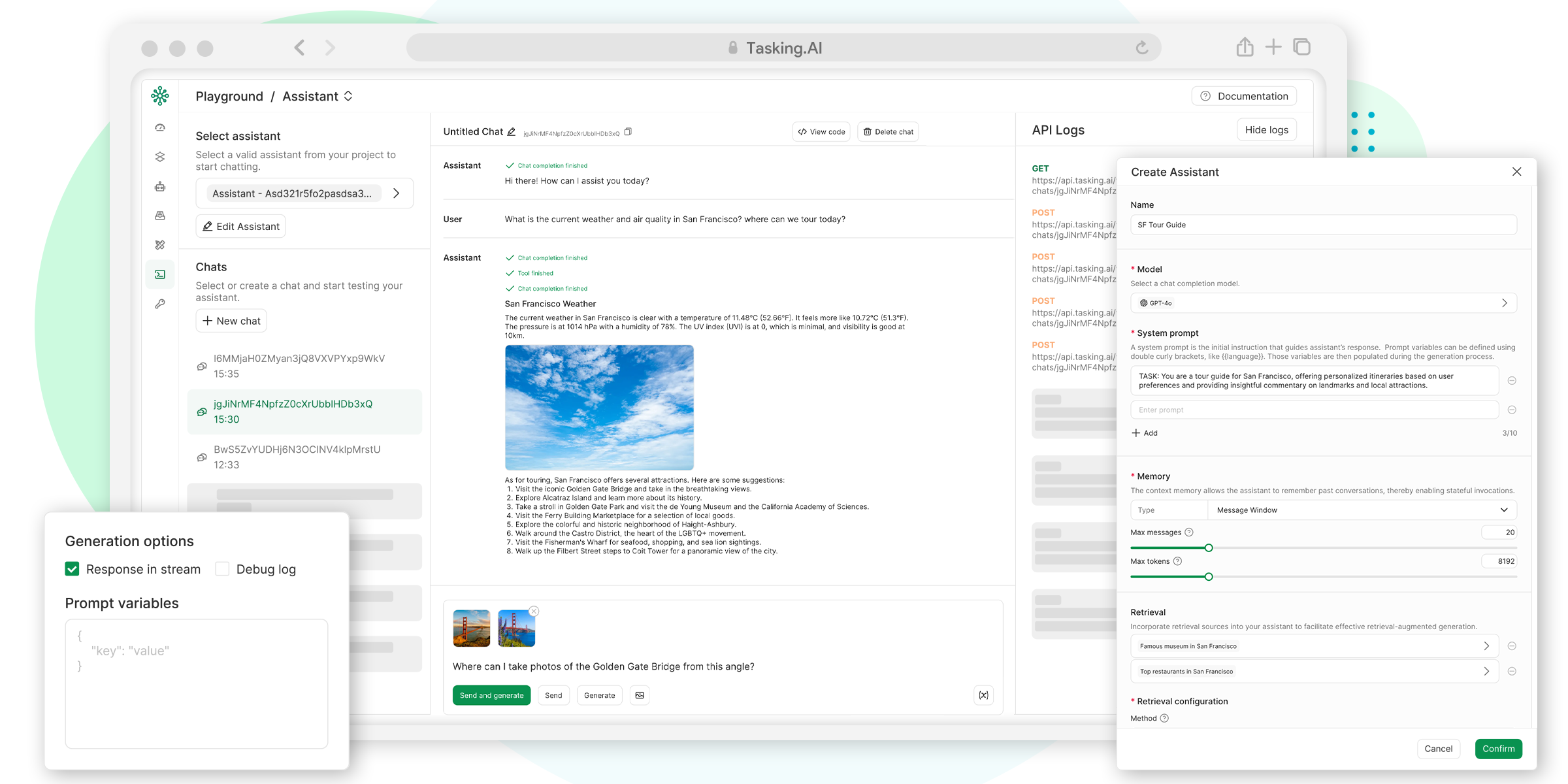

- 提示词开发与调试:

- 提供一个名为

Playground的可视化环境,用于提示词的交互式调试和效果对比。 - 支持提示词的版本管理,方便迭代和回溯。

- 提供一个名为

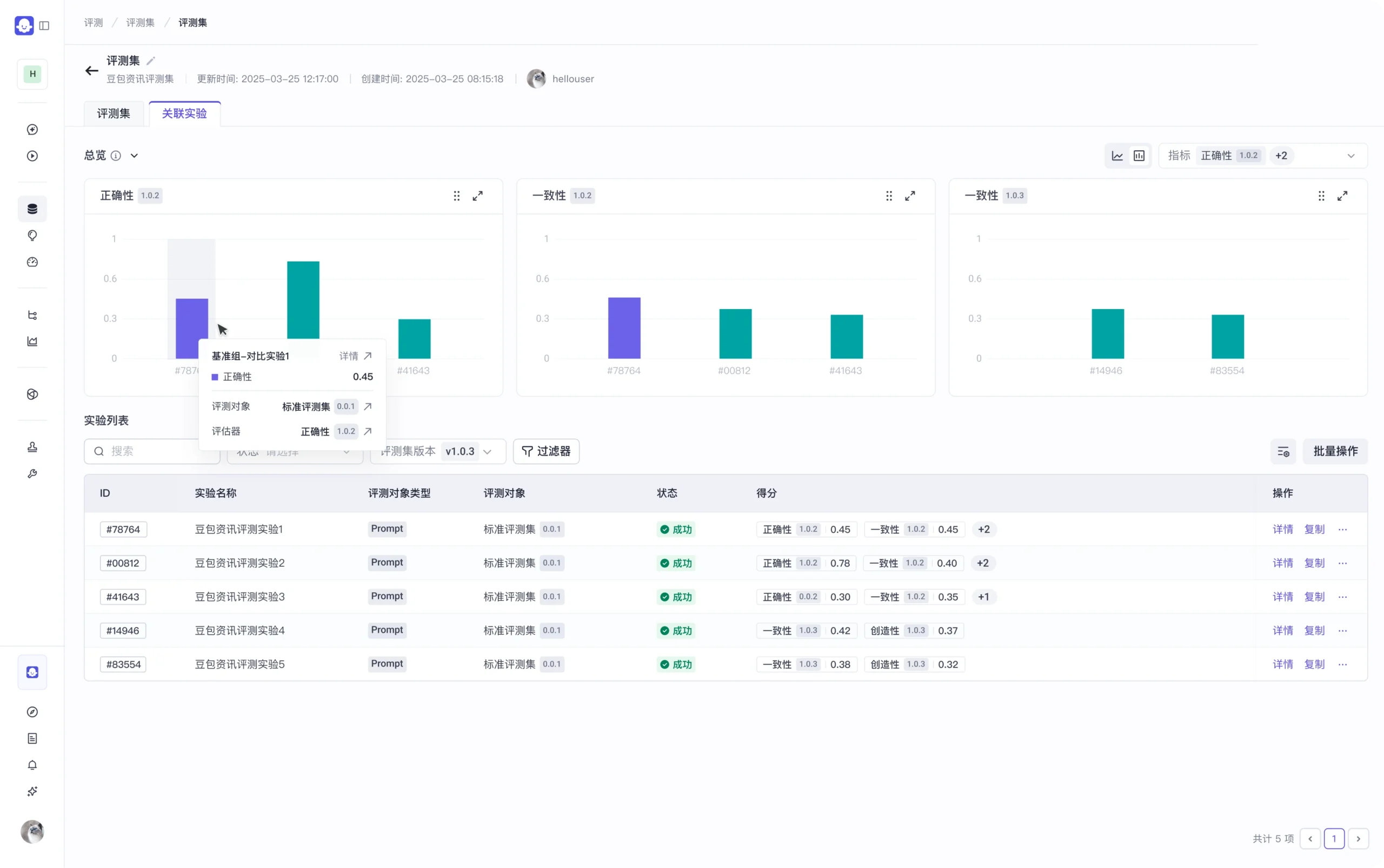

- 智能体评估:

- 支持管理用于测试的评测数据集。

- 支持管理评测器(Evaluator),定义评估标准和方法。

- 支持管理评测实验,系统化地运行测试并分析结果。

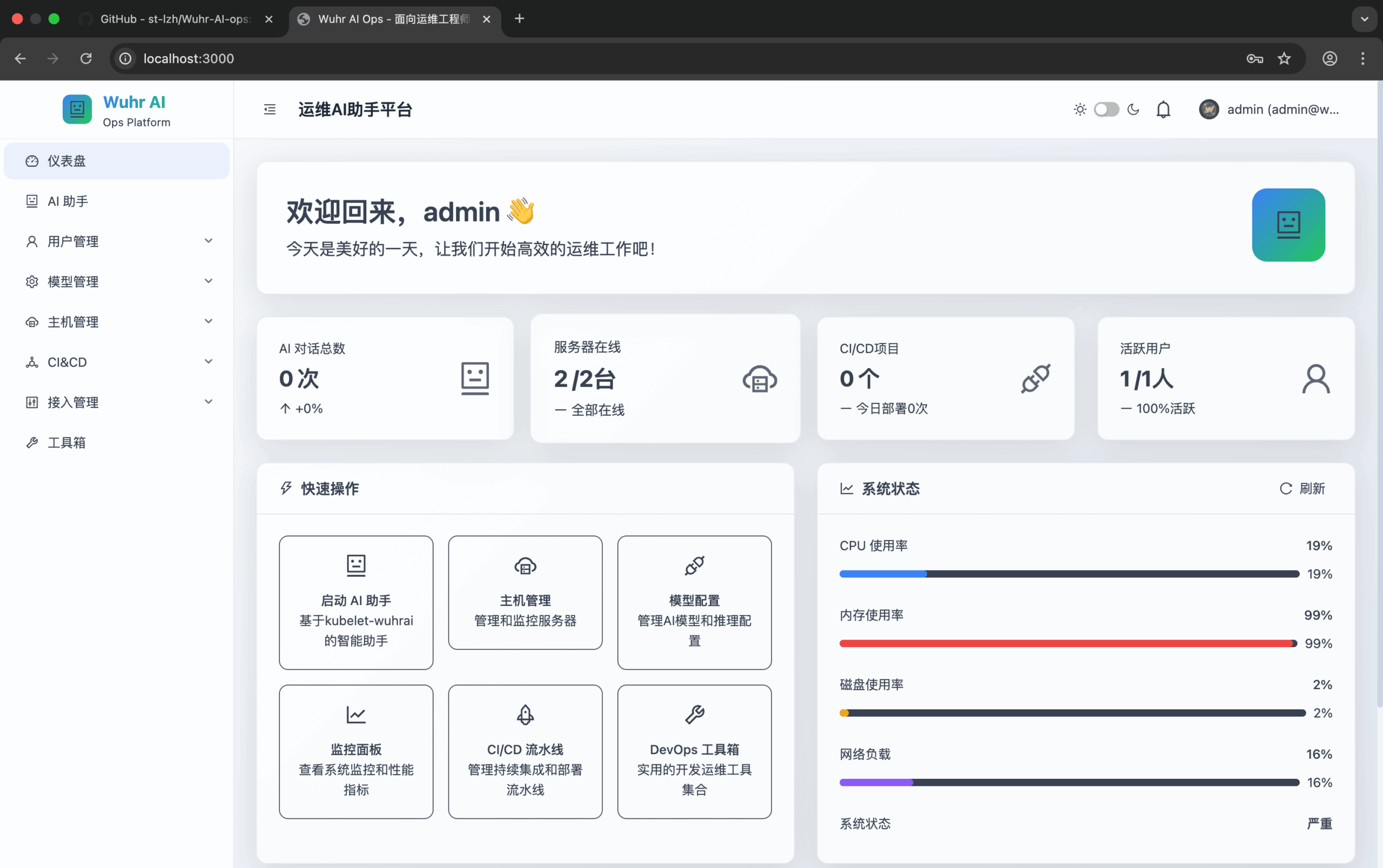

- 可观测性 (Observation):

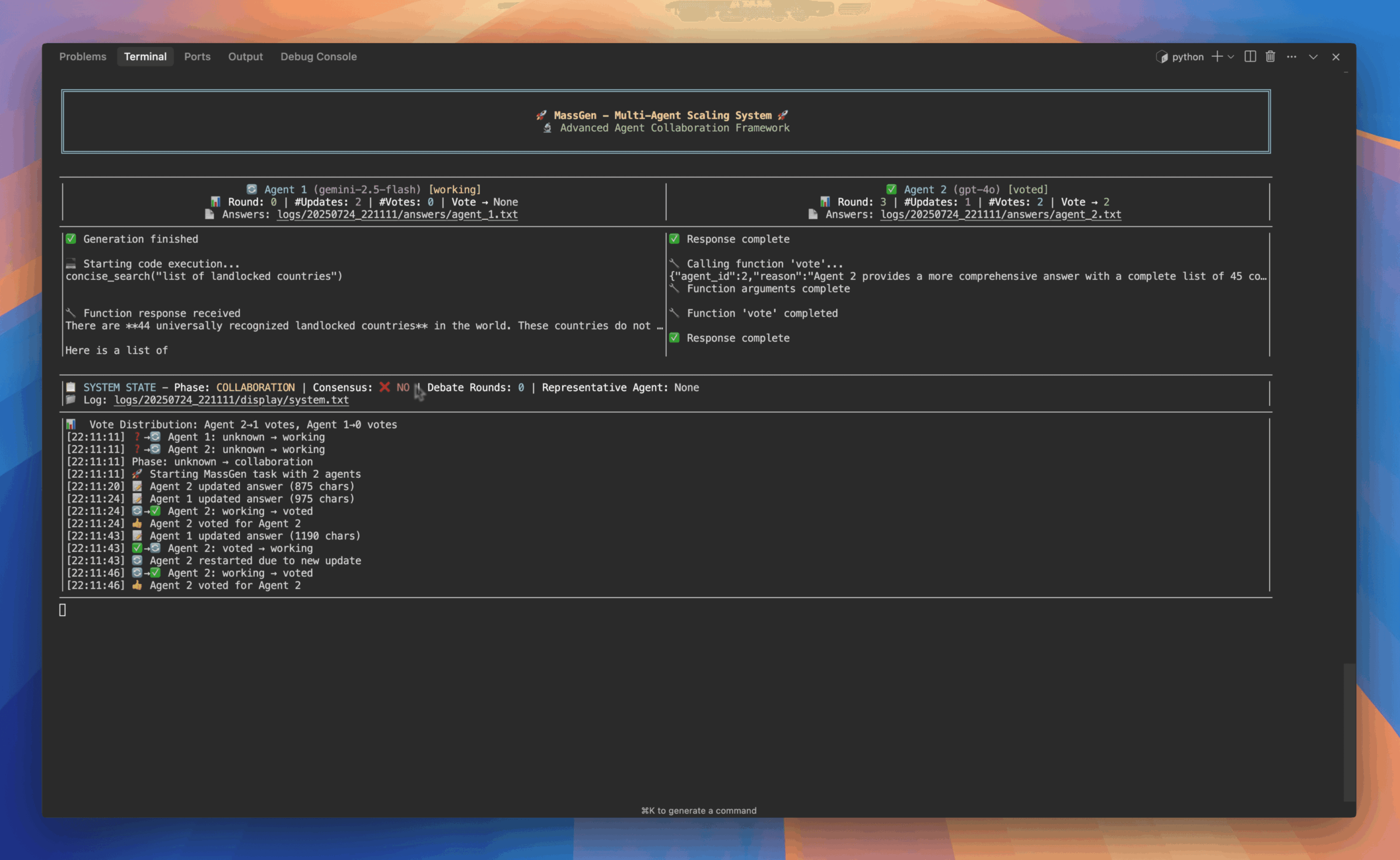

- 提供多语言SDK,用于上报智能体在运行过程中的详细数据(Trace)。

- 提供Trace数据的可视化查询与分析界面,完整还原执行链路。

- 模型管理:

- 通过集成的Eino框架,支持接入并管理多种大语言模型,例如OpenAI和火山方舟(Volcano Ark)的模型。

使用帮助

Coze Loop为开发者提供了一整套用于AI智能体生命周期管理的工具,可以通过私有化部署来使用。下面是关于如何部署和使用该平台的详细指南。

环境要求与部署流程

在开始安装之前,需要确保您的系统满足基本要求,并已安装好必要的依赖软件。

1. 系统要求:

- CPU: 最低 2 核

- 内存: 最低 4 GB

- 软件: 必须预先安装

Docker和Docker Compose,并确保Docker服务已经处于运行状态。

2. 部署步骤:

整个部署过程非常便捷,主要分为获取代码和启动服务两个步骤。

第一步:获取源代码使用 git 命令从GitHub克隆项目的源代码到您的本地计算机。

git clone https://github.com/coze-dev/cozeloop.git

第二步:配置与启动服务

- 进入项目根目录:

cd cozeloop - 配置模型: Coze Loop 的核心功能依赖大语言模型。您需要参考官方的模型配置文档,在

conf/model目录下创建并修改您的模型配置文件,填入API地址和访问凭证(API Key)等信息。 - 启动服务: 项目已经配置好了

docker-compose.yml文件。直接运行以下命令即可启动所有服务:docker-compose up -d - 首次启动时,系统需要下载相关镜像,可能会花费一些时间。服务默认以开发模式启动,这意味着您在后端修改了代码文件后,服务会自动重新加载,无需手动重启或重新部署,非常便于二次开发。

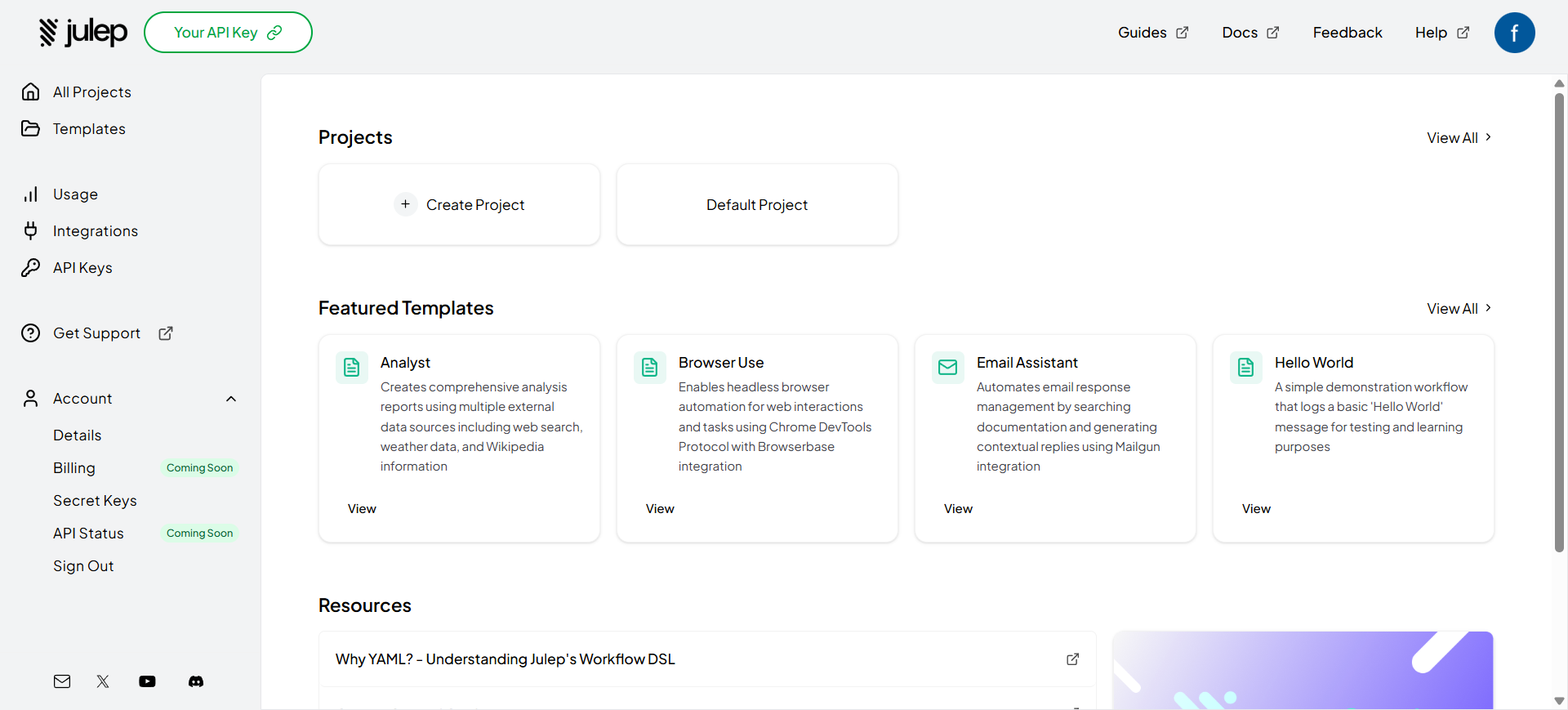

核心功能操作与开发指南

关于如何使用Coze Loop的各项功能,您可以参考官方提供的详细文档。

- 提示词开发与调试: Coze Loop提供了一套完整的提示词开发工作流。您可以参考官方文档学习如何在

Playground中进行调试和版本管理。 - 评估: 评估功能提供了标准化的评测数据管理、自动化的评估引擎和全面的实验结果统计。具体使用方法请参考评估快速上手文档。

- Trace上报与查询: 平台支持自动上报在

Playground中调试时产生的Trace数据。对于您自己的外部应用,则需要集成SDK来上报。具体集成方法请参考Trace集成文档。 - SDK的使用: Coze Loop提供了多语言版本的SDK,这些SDK同时适用于商业版和开源版。在开源版中使用时,开发者仅需在初始化SDK时修改部分参数配置即可。详情请参阅开源版使用SDK的文档。

应用场景

- 智能体上线前的质量保障在一个新的AI客服机器人上线前,开发团队可以使用评估模块,建立一套包含数百个业务问题的评测集。通过自动化评测,量化分析机器人在各种问题下的回答准确率和合规性,确保其服务质量达到标准后才对用户开放。

- 提示词(Prompt)的迭代优化一个负责生成营销文案的智能体,其核心是一个复杂的提示词。开发人员可以在

Playground中不断调试和优化这个提示词,并利用版本管理功能保存每一个有效的版本。通过对比不同版本在多个大模型上的生成效果,最终选出成本和质量最优的组合。 - 生产环境问题的根源定位一个部署在生产环境的AI助手突然开始频繁出错,回答变得牛头不对马嘴。运维团队可以通过Coze Loop的Trace观测功能,快速定位到出问题的具体请求。通过查看该请求的完整执行链路,他们可能会发现是某个外部API插件调用超时导致了后续模型产生了错误的回复,从而快速找到并解决问题。

- 不同大模型的能力对比选型一个企业计划为其AI应用选择一个最合适的大模型。他们可以利用Coze Loop的评估模块,使用同一套标准评测集,对来自OpenAI、Anthropic、火山方舟等多个不同厂商的模型进行横向评测,最终根据评测报告,选择在特定业务场景下综合表现最好的模型。

QA

- Coze Loop 和 Coze Studio 是什么关系?它们都是字节跳动Coze生态下的开源项目,但分工不同。简单来说,

Coze Studio是一个AI智能体的“建造工厂”,它提供了无代码界面让你快速地把想法变成应用。而Coze Loop是这个工厂的“质检和优化实验室”,它提供专业的工具来测试、评估和监控这些被建造出来的智能体,确保它们的质量并持续提升表现。 - 这个平台是给谁用的?需要专业背景吗?Coze Loop主要面向AI应用的开发者和运营者(AIOps/LLMOps工程师)。使用这个平台需要对AI智能体的基本概念有所了解,例如什么是提示词、模型调用等。虽然它提供了可视化界面,但其核心功能(如评估、Trace分析)是为了解决开发和运维过程中的专业问题而设计的,因此更适合有一定技术背景的用户。

- 平台支持哪些大语言模型?Coze Loop通过一个名为Eino的框架来集成大语言模型,理论上可以支持多种模型。根据官方文档,它已明确支持接入OpenAI和火山方舟(Volcano Ark)等主流模型服务。用户可以根据自己的需求,在配置文件中添加和管理自己的模型。

- Trace功能是如何实现的?我需要修改我的应用代码吗?是的,对于您自己的应用需要进行少量修改。为了让Coze Loop能够观测到您的智能体是如何运行的,您需要在您的应用代码中集成Coze Loop提供的SDK。当您的智能体处理用户请求时,调用SDK的接口来上报数据。这样,完整的执行链路信息才会被发送到Coze Loop平台进行记录和分析。好消息是,官方SDK同时支持商业版和开源版,您只需在初始化时进行简单的参数修改即可。